지도학습-예측회귀 문제

Question : 시간이 지난 뒤 다은 훈련 집합은 어디에 위치해 있을까?

-> 이때 데이터 모델링을 사용.

훈련데이터들이 직선을 이루므로 선형모델로 선택

이러한 추세를 예측하는것을 우리는 회귀라고 부릅니다.

목표값(y) = w(특징값) + b로 표현 가능

w : 가중치

b : bias

여기서 기계학습이 하는 일은 훈련데이터를 통해 모델을 선택하고 최적의 매개변수 w, b를 찾는 일이다.

기계학습을 마친 후, 최적의 매개변수를 통해 새로운 특징값이 들어왔을 때 목표치를 정확하게 예측하는 것이다.

그러면 기계학습이 찾아낸 최적의 매개변수가 좋다는 것을 어떻게 알수 있을까??

(훈련데이터를 모두 소화했다고 그것이 최적의 매개변수라고 볼 수는 없다.

새로운 특징벡터의 목표치를 정확하게 예측 할수 있어야만 기계학습 알고리즘이 잘 학습되었다고 말 할 수 있다. - 일반화 능력)

지도학습-선형회귀 문제

먼저 최적의 매개변수를 찾기위해 훈련데이터의 오차를 줄여가는 방식으로 접근한다.

훈련데이터에 대한 기계학습 알고리즘 판단 척도는 다음과 같다.

목적함수, 비용함수, 손실함수 = 오차를 나타내는 함수(정답으로부터 얼마나 차이가 있는지 나타내는 함수)

(다시말해 목적함수, 비용함수, 손실함수는 훈련데이터에 대해서 기계학습이 잘 되고있는지 아닌지 판단할 수 있는 척도이다.)

1. 평균제곱오차(MSE: Mean Squared Error)

: 예측치와 정답 값 또는 목표치와의 차이를 제곱한 다음 평균을 낸 식

기계학습을 공식화 하면 다음과 같다.

Θ를 변수로 J(Θ)라는 목적함수를 minimize하는 argument Θ를 고르는 문제이다.

Question : 그러면 과연 어떻게 Θ를 줄여 나갈 수 있을까?

-> 미분을 이용 한다.

어떤 함수의 값을 작게 만들고 싶으면, 그 함수를 변수에 대해서 미분한 다음에 미분값의 반대방향으로 움직이면 바로 그 함수값이 작아지는 방향으로 움직일 수 있다.

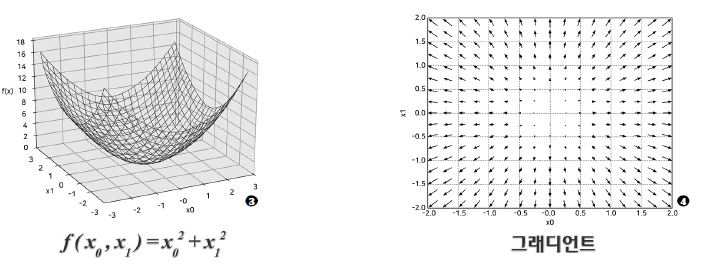

2. 경사하강법(다변수함수와 그래디언트)

이런 함수의 최솟값을 우리가 눈으로 보면 가운데 있는 값임을 알 수 있다.

저 함수에서 미분을 취하게 되면 그래디언트라고 표현된 화살표로 표현된다.

저 그래디언트의 반대 방향으로 움직이게 된다면 우리는 중심에 서서히 도달할 수 있을 것이다.

이러한 방식을 경사하강법(Gradient Descent Method)라고 한다.

다시말해서 편미분을 통해 그래디언트를 구하고 이를 이용하여 변수를 갱신하여 최소값을 찾아내는 방법

(선형회귀 뿐만 아니라, 기계학습 모델의 파라미터를 구하는 데 가장 범용적으로 사용되는 방법 중 하나)

이를 수학적으로 표현하면 다음과 같다.

하지만 이러한 방식으로는 모든 문제를 해결 할수 없다.

만약 데이터가 이러한 경우는 어떻게 할 것인가?

다음 포스팅에 비선형 모델에 대해서 언급 하겠습니다.

'0 + 자동차 > 0 + 자율주행' 카테고리의 다른 글

| [자율주행] 예제를 통해 알아보는 기계학습의 개념(비선형모델) (0) | 2021.06.23 |

|---|---|

| [자율주행] 자율주행과 인공지능 개념 (0) | 2021.06.19 |